【特集:AI 社会と公共空間】

人を評価する人工知能が人間同士の関係に与える影響とその倫理的含意

2019/02/05

4 人を評価する人工知能の問題点

しかし人工知能による人間の評価・類型化が応用されるのはマーケティングにおいてばかりではない。企業による人材登用や人事評定、あるいは司法(警察や裁判)の場においても人工知能は使われている。このようなサービスを提供している側は、それが人間と違って「偏りがない」、「好みに左右されない」、「正確である」と宣伝するのが常である。しかし実際にはそこにはアルゴリズムを作った人間の好みやバイアス、そして学習に利用されたデータの持つバイアスなどが反映されているということが指摘される(3)。

AC Global Risk社が開発している「遠隔リスク評価(Remote Risk Assessment; RRA)」というシステムには人工知能による人間評価の様々な問題点が顕著に現れている(4)。このシステムは電話越しの十分程度の会話(決められた質問に対して母国語で答える)をもとに、その内容ではなく声の調子のみによって相手が危険人物であるどうかを判定するという。「移民を徹底的に精査せよ」というトランプ大統領の要求に対する答えとして、AC Global Risk社はRRAを「アメリカや他の国が現在、直面している歴史的な難民危機(monumental refugee crisis)に対する究極のソリューション」と宣伝している。AC Global Risk社はソフトウェアの詳細に関するThe Interceptの質問に答えることを拒否しているが、公開されている材料をレビューした専門家はこれを「たわごと(bullshit)」、「いかさま(bogus)」と呼んでいる。音声感情認識の権威であるBjörn SchullerはThe Interceptの取材に対して「何らかの精度で声だけから嘘を見破れるという印象を与えることは倫理的に問題がある。そんなことができると宣伝する人間がいたら、彼らこそがリスクだとみなされるべきだ」と述べている。アメリカの入国審査では、人を捜査したり入国拒否したりする際、喋り方や見た目が口実として使われている。RRAはそのようなバイアスを「ルーティンとして蔓延させ、一見『客観的』に見せるかもしれない」と専門家は危惧している。

しかしRRAやそれに類する人間評価アルゴリズムは現在、社会のあちこちで使われている。そして多くの場合、それらは宣伝されるほど正確でもないし、バイアスを免れているわけでもない。アメリカで再犯の可能性などについて推測するために使われ、量刑の決定の際にも参考にされるCOMPASというシステムは、素人によるあてずっぽうの推測にも劣る程度の精度しかなく、また人間と同様のバイアスを持っていたことが判明した(5)。アマゾン社が秘密裏に開発していた人工知能による人材評価システムは女性を低く評価するバイアスを持っていたことが判明し、開発チームがその問題に対処することができなかったために破棄された(6)。こういった問題が次々に明らかになっているにもかかわらず、企業や政府はアルゴリズムで人を評価することに熱心である。なぜならそれは複雑で難しい問題に対する、単純で効率的な「解決」であるからだ。

5 リスクとしての他者

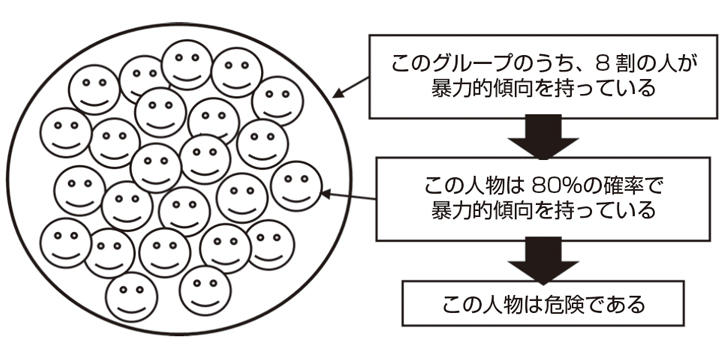

人間評価アルゴリズムはデータに基づいて人々を分類、クラスタリングする。そして特定の集団に属する人間に対して一定の評価、ラベリングを行う。この推論に基づいて、リスクが高いと判断された人間は、例えば企業で採用を見送られる、長い刑期を課される、入国を拒否される等々、不利な状況に置かれることになる。例えば暴力的な人物が高い割合で含まれると評価された集団のメンバーは、暴力的である可能性が高いと見なされ、リスクとして排除される(図1)。最も極端な例は、アメリカによる「テロとの戦い」で用いられる「シグネチャー攻撃」だろう。アメリカはアフガニスタン、パキスタンなどで、人々の年齢、行動のパターン、居場所、人的なつながりのネットワークなどのデータに基づいてある人物がテロリストであるかどうかを推定して、ドローンによる爆撃を行っている。実際にアメリカを攻撃する意図や計画を持っているかどうかにかかわらず、テロリストに共通する特徴を十分に持っている人間であれば、テロリストと見なして攻撃しているのである(7)。

このような方法論の根底にある(そしてこの方法論を実践することによって社会に蔓延する)のは、他者をコンピュータやスマートフォンなどの機械によって処理できるデータの束として捉え、そして自分にとっての潜在的な損害あるいは利益としてのみ捉える見方である。機械学習システムは、ウェブ上にあふれる膨大なデータから、複雑な属性の組み合わせを持った人間が、何かしら「リスキー」である可能性を検知する。「リスキー」だと判断された人々は、しばしば効率のために十把一絡げにして、かつ誤った「客観性」の名の下に、切り捨てられてしまう。一人一人の個人が、本当に危険なのかが精査されることはない。なぜならそうすることは非効率的だからである。それよりはリスクとしてラベリングされた人々すべてを切り捨てる方が効率的であり、従って「合理的」なのである。そこでは他者は血の通った個人として扱われず、単なるデータポイントとして扱われる。もしもこの際に参照される属性が民族やジェンダーや宗教などであるとき、それは差別であり、アンフェアであるとして批判される。しかしながらビッグデータに基づく人間評価システムは、現在すさまじい勢いで新たな差別の種を生み出している。さらに言えば前節のアマゾン社の例に示される通り、自動的人間評価システムは古くからある差別を気づかれないうちに判断に紛れ込ませていることもしばしばである。

2019年2月号

【特集:AI 社会と公共空間】

| カテゴリ | |

|---|---|

| 三田評論のコーナー |